大家好,我是小寒

今天给大家分享一个超强的算法模型,Fast RCNN

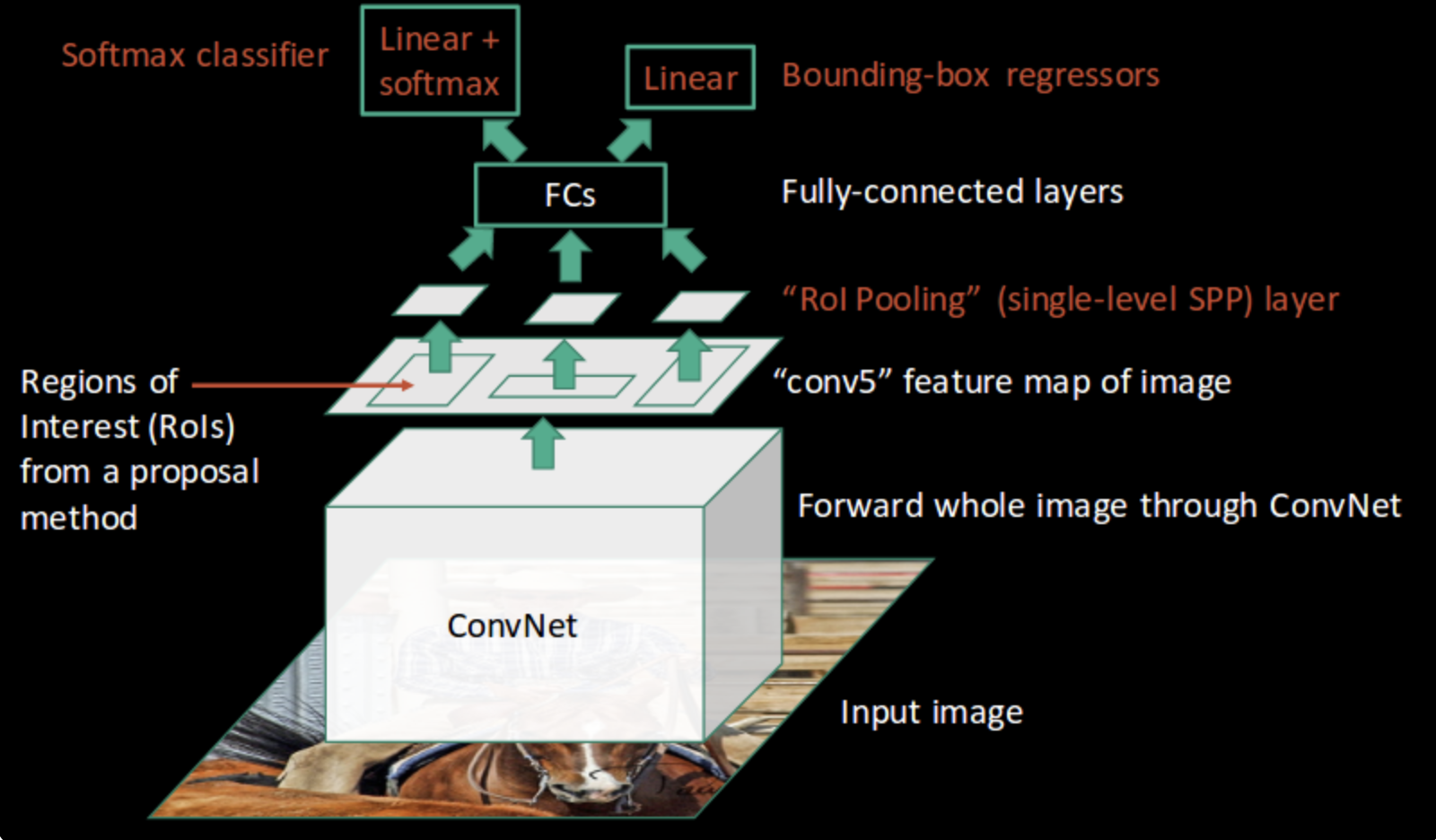

Fast R-CNN 是一种用于目标检测的深度学习模型,由 Ross Girshick 于 2015 年提出。

它是 R-CNN(Region-based Convolutional Neural Network)的改进版本,通过使用共享卷积特征和引入 ROI (Region of Interest) 池化层,提高了训练和推理的速度。

Fast R-CNN 的架构

Fast R-CNN 的架构可以分为以下几个步骤

- 输入图像和卷积特征提取

输入一张完整的图像,使用卷积神经网络(如 VGG16、ResNet 等)提取特征图。这一步只进行一次。

- 候选区域生成

使用选择性搜索或其他方法生成一系列候选区域(ROI)。

然后将这些候选区域在特征图上进行映射。

- ROI 池化层

对每个候选区域,使用 ROI 池化层将不同大小的候选区域变换为固定大小的特征向量。

ROI 池化通过将候选区域划分为固定数量的网格,并在每个网格中进行最大池化操作。

- 全连接层和分类

将 ROI 池化输出的特征向量输入全连接层,进一步提取特征。

使用 Softmax 分类器对每个 ROI 进行分类,并使用线性回归器进行边界框的精细化调整。

- 损失函数

Fast R-CNN 使用多任务损失函数,包括分类损失和边界框回归损失。

分类损失使用交叉熵,边界框回归损失使用平滑 L1 损失。

代码示例

下面是一个使用 PyTorch 实现 Fast R-CNN 的简单示例代码。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision.models import vgg16

from torchvision.ops import roi_pool

# 定义 Fast R-CNN 模型

class FastRCNN(nn.Module):

def __init__(self, num_classes):

super(FastRCNN, self).__init__()

# 使用预训练的 VGG16 作为基础卷积网络

vgg = vgg16(pretrained=True)

self.features = nn.Sequential(*list(vgg.features.children())[:-1]) # 去掉最后一个池化层

self.classifier = nn.Sequential(*list(vgg.classifier.children())[:-1]) # 去掉最后一层分类层

# 分类和回归层

self.cls_score = nn.Linear(4096, num_classes)

self.bbox_pred = nn.Linear(4096, num_classes * 4)

def forward(self, images, rois):

# 提取共享卷积特征

feature_map = self.features(images)

# 对每个 ROI 进行池化操作

pooled_features = roi_pool(feature_map, rois, output_size=(7, 7), spatial_scale=1.0/16.0)

# 通过全连接层

pooled_features = pooled_features.view(pooled_features.size(0), -1)

fc7 = self.classifier(pooled_features)

# 分类得分和边界框回归

cls_score = self.cls_score(fc7)

bbox_pred = self.bbox_pred(fc7)

return cls_score, bbox_pred

# 示例:使用 Fast R-CNN 模型

num_classes = 21 # 假设有 20 个目标类别和 1 个背景类

model = FastRCNN(num_classes=num_classes)

# 定义损失函数和优化器

criterion_cls = nn.CrossEntropyLoss()

criterion_bbox = nn.SmoothL1Loss()

optimizer = optim.SGD(model.parameters(), lr=0.001, momentum=0.9, weight_decay=0.0005)

# 假设输入图像和 ROI

images = torch.rand(2, 3, 224, 224) # 输入两张 224x224 大小的图像

rois = torch.tensor([[0, 0, 0, 100, 100], [0, 50, 50, 150, 150], [1, 60, 60, 160, 160]], dtype=torch.float) # 示例 ROI

# 前向传播

cls_score, bbox_pred = model(images, rois)

# 假设标签

labels = torch.tensor([1, 0, 2]) # 每个 ROI 的分类标签

bbox_targets = torch.rand(3, num_classes * 4) # 每个 ROI 的边界框回归目标

# 计算损失

loss_cls = criterion_cls(cls_score, labels)

loss_bbox = criterion_bbox(bbox_pred, bbox_targets)

# 反向传播和优化

loss = loss_cls + loss_bbox

optimizer.zero_grad()

loss.backward()

optimizer.step()

Fast R-CNN 的优势

- 高效性

共享特征图,大幅减少计算冗余,提高处理速度。

- 精度高

相比 R-CNN,Fast R-CNN 提高了检测精度。

- 简化训练流程

单阶段训练过程,易于实现和调试。

Fast R-CNN 的不足

尽管 Fast R-CNN 解决了 R-CNN 的一些缺点,但仍然依赖外部的候选区域生成方法(如选择性搜索),这在检测速度上仍然存在瓶颈。

后续的 Faster R-CNN 通过引入区域建议网络(RPN)进一步解决了这一问题。